使用 DeepChat 的 3 步訓練示例,對捷智算平臺提供的 NVIDIA H100 SXM5 與 NVIDIA A100 SXM4 進行 GPU 基準測試。

目標

我們使用DeepChat 的 3 步訓練示例,對捷智算平臺提供的NVIDIA H100 SXM5 實例(由 NVIDIA H100 Tensor Core GPU 提供支持)進行了激動人心的 GPU基準測試。我們將性能與參考 NVIDIA A100 SXM4 Tensor Core 系統進行比較,并在 128 臺服務器上的 1,024 個 GPU 上對其可擴展性進行壓力測試。

準備事項

每臺服務器配備 8 個 NVIDIA H100 SXM5 GPU 和 8 個 400Gb/s NDR InfiniBand 鏈路。這相當于 640GB 的 GPU 內存和 3200Gb/s 的節點間帶寬。

利用完全無阻塞的軌道優化網絡拓撲,我們最大限度地提高了全性能并減少了網絡沖突,確保服務器之間的InfiniBand 性能大于 750Gbit/s ,這通過一對 InfiniBand 端口之間的雙向 ib_write_bw 測試來測量。

所有服務器均預裝了 Lambda Stack、InfiniBand 驅動程序和 deepspeed 0.10.0,并同步到共享存儲以用于訓練數據和預訓練權重。

主要結果

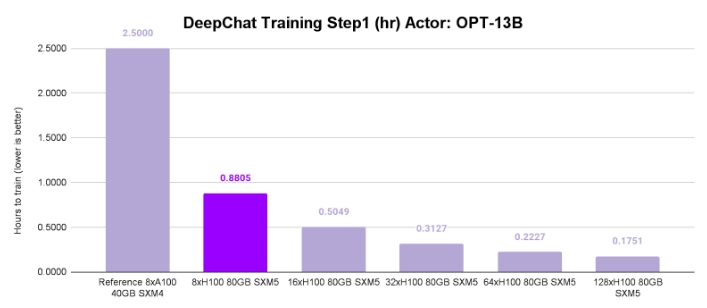

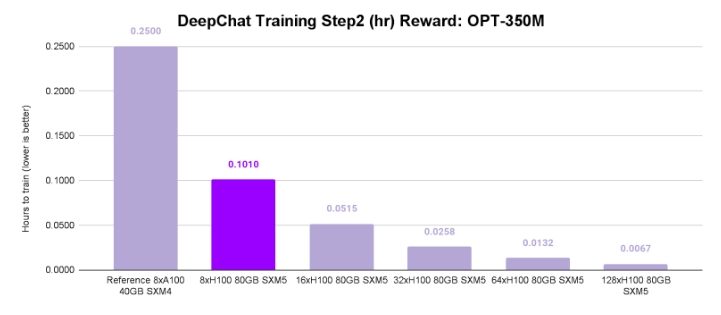

捷智算平臺的 NVIDIA H100 SXM5 與 NVIDIA A100 SXM4 實例在 FP16 中的 3 步強化學習人類反饋 (RLHF) 管道上的正面比較顯示:

步驟 1(OPT-13B Zero3):NVIDIA H100 速度提高 2.8 倍。

步驟 2(OPT-350M Zero0):NVIDIA H100 獲得 2.5 倍速度優勢。

步驟 3(OPT-13B Zero3 加 OPT-350M Zero0):NVIDIA H100 以 3.1 倍的速度提升遙遙領先。

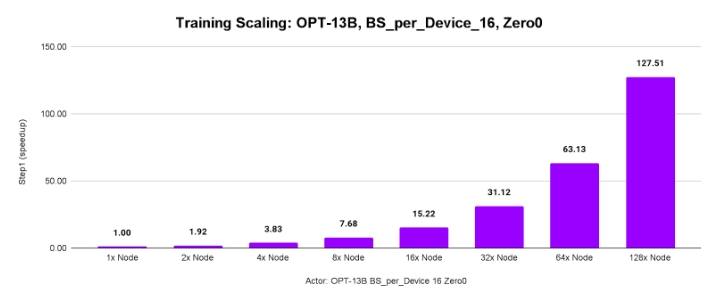

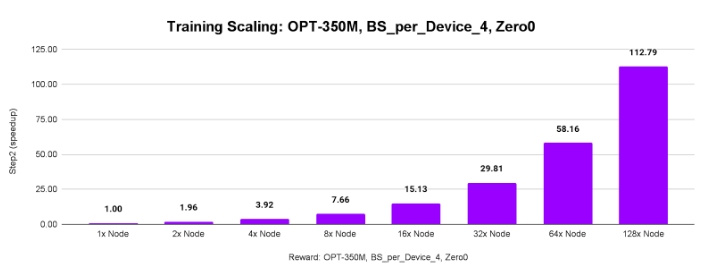

測試分布式訓練可擴展性:

大型模型(OPT-13B)和更大的批次(16 個樣本/GPU)導致 128 臺服務器的吞吐量達到 127.51 倍。

較小的模型(OPT-350M)和較小的批次(4 個樣本/GPU)仍然令人印象深刻,128 臺服務器的吞吐量達到 112.79 倍。

結論

與 NVIDIA A100 SXM4 系統相比,NVIDIA H100 SXM5 系統上的 DeepSpeed 訓練速度提高了 2.5 倍至 3.1 倍。捷智算平臺配備 80GB NVIDIA H100 SXM5 GPU、NIC 與 GPU 比率為 1:1 的 InfiniBand 連接以及軌道優化網絡。它們可以在數千個 GPU 上提供前所未有的性能和可擴展性。